पिछली तंत्रिका शुद्ध गोल्फिंग चुनौतियां ( यह और वह ) मुझे एक नई चुनौती देने के लिए प्रेरित करती हैं:

चुनौती

सबसे छोटा फीडफॉर्वर्ड न्यूरल नेटवर्क खोजें, जिसमें किसी भी 4-आयामी इनपुट वेक्टर को पूर्णांक प्रविष्टियों के साथ , नेटवर्क आउटपुट साथ एक समन्वय-वार त्रुटि से छोटी है ।

स्वीकार्यता

इस चुनौती के लिए, एक फीडफॉरवर्ड न्यूरल नेटवर्क को परतों की संरचना के रूप में परिभाषित किया गया है । एक परत एक समारोह है कि एक मैट्रिक्स द्वारा निर्दिष्ट किया जाता के वजन , एक वेक्टर के पूर्वाग्रहों , और एक सक्रियण समारोह coordinate- लागू किया जाता है कि बुद्धिमान:

चूंकि सक्रियण कार्यों को किसी भी कार्य के लिए ट्यून किया जा सकता है, इसलिए हमें इस चुनौती को दिलचस्प बनाए रखने के लिए सक्रियण कार्यों के वर्ग को प्रतिबंधित करना होगा। निम्नलिखित सक्रियण कार्यों की अनुमति है:

पहचान।

Relu।

Softplus।

अतिशयोक्तिपूर्ण स्पर्शज्या।

अवग्रह।

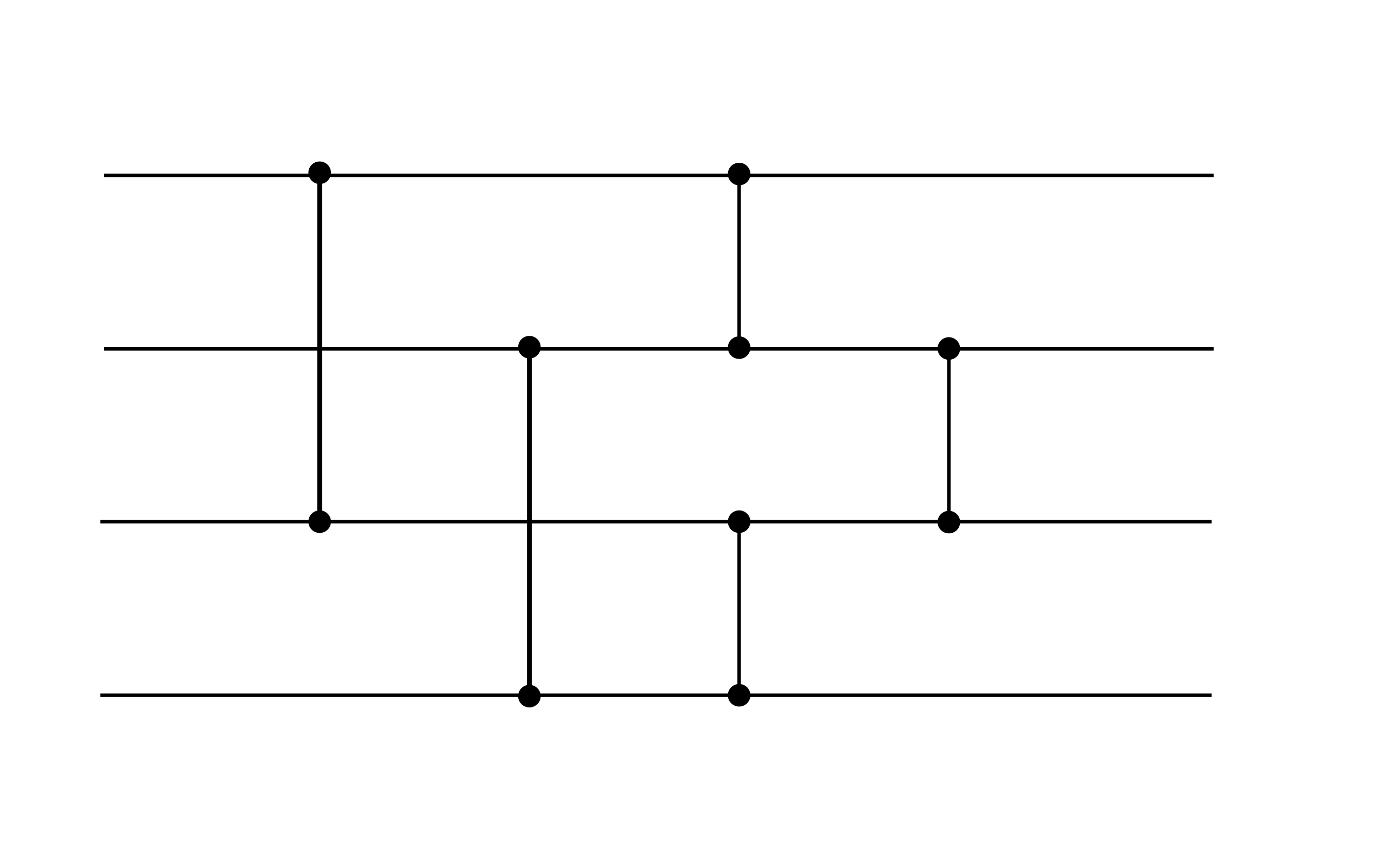

कुल मिलाकर, एक स्वीकार्य तंत्रिका शुद्ध रूप ले लेता है कुछ के लिए , जहां प्रत्येक परत वजन द्वारा निर्दिष्ट किया जाता , पूर्वाग्रहों , और एक सक्रियण समारोह उपरोक्त सूची से उदाहरण के लिए, निम्न तंत्रिका जाल स्वीकार्य है (जबकि यह इस चुनौती के प्रदर्शन लक्ष्य को पूरा नहीं करता है, यह एक उपयोगी गैजेट हो सकता है):

यह उदाहरण दो परतों को प्रदर्शित करता है। दोनों परतों में शून्य पूर्वाग्रह हैं। पहली परत ReLU सक्रियण का उपयोग करती है, जबकि दूसरी पहचान सक्रियण का उपयोग करती है।

स्कोरिंग

आपका स्कोर नोनज़रो वेट और बायसेस की कुल संख्या है ।

(उदाहरण के लिए, ऊपर दिए गए उदाहरण में 16 का स्कोर है क्योंकि पूर्वाग्रह वैक्टर शून्य हैं।)